-

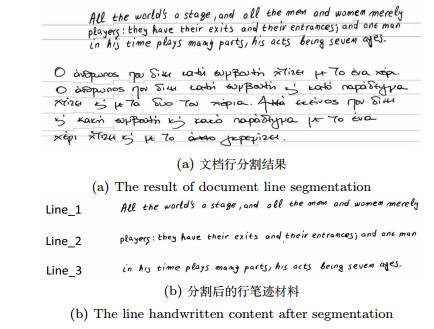

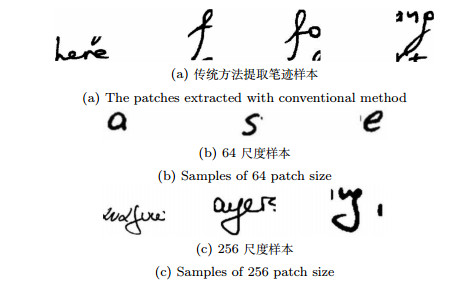

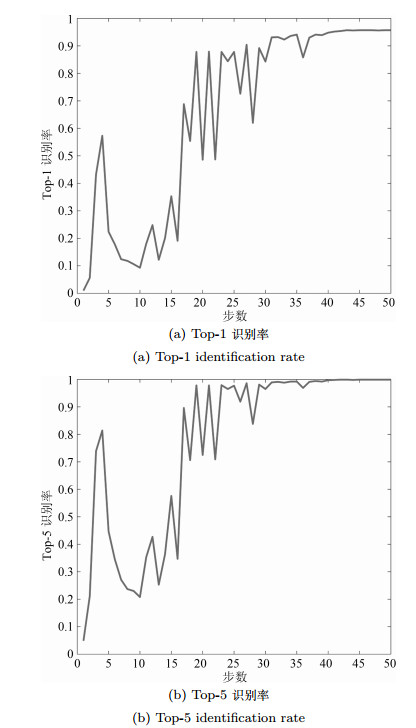

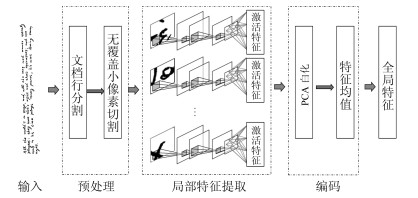

摘要: 离线笔迹鉴别在司法鉴定与历史文档分析中有重要作用.当前的主要离线笔迹鉴别都是基于局部特征提取的方法, 其在笔迹检索中严重依赖于数据增强和全局编码, 在笔迹识别中需要较多的笔迹信息.针对这一问题, 本文提出一种基于统计的文档行分割与深度卷积神经网络相结合的离线笔迹鉴别方法(DLS-CNN).首先, 使用基于统计的文档行分割方法将笔迹材料分割成小的像素块; 然后, 用优化后的残差神经网络作为识别模型; 最后, 对局部特征使用取均值法进行编码.在ICDAR2013和CVL这两个标准数据集上的实验结果表明, 该方法能有效获得鲁棒的局部特征, 从而仅需要少量的笔迹信息就能取得较高的识别率, 而且不需依赖于数据增强和全局编码就能取得较好的检索效果.实验代码地址:https://github.com/shiming-chen/DLS-CNN.Abstract: Off-line writer identification plays an important role in forensics and historical document analysis. The current well-known off-line writer identification approaches are based on local feature extraction. They rely heavily on data augmentation and global encoding for writer retrieval, and need a great number of written contents for writer recognition. This paper proposes a new off-line writer identification method, called DLS-CNN, which combines document line segmentation in terms of statistic and deep convolutional neural network. More precisely, handwriting documents are segmented into patches using document line segmentation at first. Secondly, an improved residual neural network serves as the identification model. Finally, the mean value of all local features vectors are used as final global features for writer identification. Experimental results on ICADAR2013 and CVL benchmark datasets show that, due to the extracted robust local features, DLS-CNN achieves higher identification rate with fewer written contents, and better retrieval result without data augmentation and global encoding. All the experiment codes are available at https://github.com/shiming-chen/DLS-CNN.

-

Key words:

- Writer identification /

- writer retrieval /

- document line segmentation /

- convolutional neural network (CNN) /

- features extraction

1) 本文责任编委 金连文 -

表 1 ResNet-50结构

Table 1 The structure of ResNet-50

Layer name Layers Output size Conv1 7 $\times$ 7, 64, Stride 2 112 $\times$ 112 Conv2-x1 3 $\times$ 3 Max pool, Stride 2 56 $\times$ 56 Conv2-x2 $\left[\begin{array}{c} 1 \times 1, 64\\ 3 \times 3, 64 \\ 1 \times 1, 256\end{array}\right] \times 3$ 56 $\times$ 56 Conv3-x $\left[\begin{array}{c} 1 \times 1, 128 \\ 3 \times 3, 128 \\ 1 \times 1, 512\end{array}\right] \times 4$ 28 $\times$ 28 Conv4-x $\left[\begin{array}{c} 1 \times 1, 256 \\ 3 \times 3, 256 \\ 1 \times 1, 1 024 \end{array}\right] \times 6$ 14 $\times$ 14 Conv5-x $\left[\begin{array}{c} 1 \times 1, 512 \\ 3 \times 3, 512 \\ 1 \times 1, 2 048 \end{array}\right] \times 3$ 7 $\times$ 7 Global average pool 1 $\times$ 1 Fc, Relu, Dropout, Softmax 1 $\times$ 1 表 2 不同像素块大小的对比(%)

Table 2 Comparison of different patch sizes (%)

S-1 S-5 S-10 H-2 H-3 mAP 64尺度 87.8 94.7 97.0 57.3 36.7 76.5 256尺度 $\textbf{95.0}$ $\textbf{98.4}$ $\textbf{99.3}$ $\textbf{70.3}$ $\textbf{49.5}$ $\textbf{84.7}$ 表 3 不同特征层的对比(%)

Table 3 Comparison of different feature layers (%)

S-1 S-5 S-10 H-2 H-3 mAP 全局池化层 $\textbf{95.4}$ 97.9 98.5 63.1 41.2 79.7 全连接层 95.0 $\textbf{98.4}$ $\textbf{99.3}$ $\textbf{70.3}$ $\textbf{49.5}$ $\textbf{84.7}$ 表 4 特征数目的对比(%)

Table 4 Comparison of feature numbers (%)

S-1 S-5 S-10 H-2 H-3 mAP 128 95.2 $\textbf{98.7}$ 99.0 70.1 48.6 84.3 512 95.0 98.4 $\textbf{99.3}$ $\textbf{70.3}$ $\textbf{49.5}$ $\textbf{84.7}$ 1 024 95.0 98.4 99.0 70.0 48.8 84.1 2 048 $\textbf{96.0}$ 98.4 98.6 67.1 45.8 83.0 表 5 PCA白化的评估(%)

Table 5 Evaluation of PCA$\_$Whitening (%)

S-1 S-5 S-10 H-2 H-3 mAP 无PCA白化 88.9 97.1 98.0 63.9 47.6 82.1 有PCA白化 $\textbf{95.0}$ $\textbf{98.4}$ $\textbf{99.3}$ $\textbf{70.3}$ $\textbf{49.5}$ $\textbf{84.7}$ 表 6 与其他模型的对比(%)

Table 6 Comparison with other models (%)

S-1 S-5 S-10 H-2 H-3 mAP CS-UMD-a[3] 95.1 98.6 99.1 19.6 7.1 N/A CS-UMD-b[3] 95.0 98.6 99.2 20.2 8.4 N/A HIT-ICG[3] 94.8 98.0 98.3 63.2 36.5 N/A TEBESSA-a[3] 90.3 96.7 98.3 58.2 33.2 N/A TEBESSA-b[3] 93.4 97.8 98.5 62.6 36.5 N/A Christlein[11] 97.1 98.8 99.1 42.8 23.8 67.7 Wu[9] 95.6 98.6 99.1 63.8 36.5 N/A Nicolaou[14] $\textbf{97.2}$ $\textbf{98.9}$ 99.2 52.9 29.2 N/A Fiel[8] 88.5 96.0 98.3 40.5 15.8 N/A Christlein[24] 86.8 N/A N/A N/A N/A 78.9 DLS-CNN 95.0 98.4 $\textbf{99.3}$ $\textbf{70.3}$ $\textbf{49.5}$ $\textbf{84.7}$ -

[1] Fiel S, Kleber F, Diem M. ICDAR2017 Competition on Historical Document Writer Identification (Historical-WI). In: Proceedings of the 14th International Conference on Document Analysis and Recognition. Kyoto, Japan: IEEE, 2018. 1377-1382 [2] Asi A, Abdalhaleem A, Fecker D. On writer identification for Arabic historical manuscripts. International Journal on Document Analysis and Recognition, 2017, 2017(3-4): 1-15 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=a2cace6f868ded2b41dc027e8943b487 [3] Louloudis G, Gatos B, Stamatopoulos N. ICDAR 2013 Competition on Writer Identification. In: Proceedings of the 12th International Conference on Document Analysis and Recognition. Washington, DC, USA: IEEE, 2013. 1397-1401 [4] Cloppet F, Eglin V, Kieu V C. ICFHR2016 Competition on the Classification of Medieval Handwritings in Latin Script. In: Proceedings of the 15th International Conference on Frontiers in Handwriting Recognition. Shenzhen, China: IEEE, 2017. 1371-1376 [5] Chawki D, Somaya A M, Imran S, Abdeljalil G, He Sheng. ICFHR 2018 Competition on Multi-Script Writer Identification. In: Proceedings of the 16th International Conference on Frontiers in Handwriting Recognition. Niagara Falls, USA: IEEE, 2018. 506-510 [6] Helli B, Moghaddam M E. A text-independent Persian writer identification based on feature relation graph (FRG). Pattern Recognition, 2010, 44(6): 229-240 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=7409e0794b32b08068f2e2eda9e786c8 [7] Bertolini D, Oliveira L S, Justino E. Texture-based descriptors for writer identification and verification. Expert Systems with Applications, 2013, 40(6): 2069-2080 doi: 10.1016/j.eswa.2012.10.016 [8] Fiel S, Sablatnig R. Writer Identification and Retrieval Using a Convolutional Neural Network. In: Proceedings of the 16th International Conference on Computer Analysis of Images and Patterns. Springer International Publishing, 2015. 26-37 [9] Wu Xiang-Qian, Tang You-Bao, Wei Bu. Offline Text-Independent Writer Identification Based on Scale Invariant Feature Transform. Information Forensics and Security, 2014, 9(3): 526-536 doi: 10.1109/TIFS.2014.2301274 [10] Xing Lin-Jie, Qiao Yu. DeepWriter: A Multi-Stream Deep CNN for Text-independent Writer Identification. In: Proceedings of the 15th International Conference on Frontiers in Handwriting Recognition. Shenzhen, China: IEEE, 2017. 584-589 [11] Christlein V, Bernecker D, Honig F. Writer Identification Using GMM Supervectors and Exemplar-SVMs. Pattern Recognition, 2017, 63: 258-267 doi: 10.1016/j.patcog.2016.10.005 [12] Christlein V, Gropp M, Fiel S, Maier A. Unsupervised Feature Learning for Writer Identification and Writer Retrieval. arXiv preprint arXiv: 1705.09369, 2017 [13] Tang You-Bao, Wu Xiang-Qian. Text-Independent Writer Identification via CNN Features and Joint Bayesian. In: Proceedings of the 15th International Conference on Frontiers in Handwriting Recognition. Shenzhen, China: IEEE, 2017. 556-571 [14] Nicolaou A, Bagdanov A D, Liwicki M. Sparse radial sampling LBP for writer identification. In: Proceedings of the 13th International Conference on Document Analysis and Recognition. Tunis, Tunisia: IEEE, 2015. 716-720 [15] Chen Shi-Ming, Wang Yi-Song, Lin Chin-Teng, Ding Wei-Ping, Cao Ze-Hong. Semi-supervised Feature Learning For Improving Writer Identification. arXiv preprint arXiv: 1807.05490, 2018 [16] 李昕, 丁晓青, 彭良瑞.一种基于微结构特征的多文种文本无关笔迹鉴别方法.自动化学报, 2009, 35(9): 1199-1208 doi: 10.3724/SP.J.1004.2009.01199Li Xin, Ding Xiao-Qing, Peng Liang-Rui. Writer identification based on improved microstructure features. Acta Automatica Sinica, 2009, 35(9): 1199-1208 doi: 10.3724/SP.J.1004.2009.01199 [17] 邹杰, 孙宝林, 於俊.基于笔画特征的在线笔迹匹配算法.自动化学报, 2016, 42(11): 1744-1757 doi: 10.16383/j.aas.2016.c150563Zou Jie, Sun Bao-Lin, Yu Jun. Online handwriting matching algorithm based on stroke features. Acta Automatica Sinica, 2016, 42(11): 1744-1757 doi: 10.16383/j.aas.2016.c150563 [18] Khan F A, Tahir M A, Khelifi F. Novel geometric features for off-line writer identification. Pattern Analysis and Applications, 2016, 19(3): 699-708 doi: 10.1007/s10044-014-0438-y [19] Bertolini D, Oliveira L S, Sabourin R. DeepWriter: Multi-script writer identification using dissimilarity. In: Proceedings of the 23rd International Conference on Pattern Recognition. Cancun, Mexico: IEEE, 2017. 3025-3030 [20] Shaus A, Turkel E. Writer Identification in Modern and Historical Documents via Binary Pixel Patterns, Kolmogorov-Smirnov Test and Fisher$'$s Method. Journal of Imaging Science and Technology, 2017, 61(1): 104041-104049 doi: 10.2352/J.ImagingSci.Technol.2017.61.1.010404 [21] He S, Schomaker L. Writer identification using curvature-free features. Pattern Recognition, 2017, 63: 451-446 doi: 10.1016/j.patcog.2016.09.044 [22] Khan F A, Tahir M A, Khelifi F. Robust off-line text independent writer identification using bagged discrete cosine transform features. Expert Systems with Applications, 2017, 71(C): 404-415 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=4bd769b41a47a54429c9a8335ef2476c [23] Bulacu M, Schomaker L. Text-Independent Writer Identification and Verification Using Textural and Allographic Features. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2007, 29(4): 1-17 doi: 10.1109/TPAMI.2007.1020 [24] Christlein V, Maier A. Encoding CNN Activations for Writer Recognition. arXiv preprint arXiv: 1712.07923, 2017 [25] Louloudis G, Stamatopoulos N, Gatos B. ICDAR 2011 Writer Identification Contest. In: Proceedings of the 11th International Conference on Document Analysis and Recognition. Beijing, China: IEEE, 2011. 1475-1479 [26] Kleber F, Fiel S, Diem M, Sablatnig R. CVL-DataBase: An Off-Line Database for Writer Retrieval, Writer Identification and Word Spotting. In: Proceedings of the 12th International Conference on Document Analysis and Recognition. Washington DC, USA: IEEE, 2013. 560-564 [27] Diem M, Kleber F, Sablatnig R. Text Line Detection for Heterogeneous Documents. In: Proceedings of the 12th International Conference on Document Analysis and Recognition. In: Proceedings of International Conference on Document Analysis and Recognition. Washington DC, USA: IEEE, 2013. 743-747 [28] Marti U V, Bunke H. The IAM-database: an English sentence database for offline handwriting recognition. International Journal on Document Analysis and Recognition, 2002, 5(1): 39-46 [29] Liu Cheng-Lin, Yin Fei, Wang Da-Han, Wang Qiu-Feng. CASIA online and offline Chinese handwriting databases. In: Proceedings of the 11th International Conference on Document Analysis and Recognition. Beijing, China: IEEE, 2011. 37-41 [30] Arivazhagan M, Srinivasan H, Srihari S. A statistical approach to line segmentation in handwritten documents. Document Recognition and Retrieval XIV, 2007, 6500(T): 1-11 [31] Liu Ji-Ming, Tang Yuan-yan. Adaptive Image Segmentation with Distributed Behavior-based Agents. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1999, 21(6): 544-551 doi: 10.1109/34.771323 [32] You Xin-Ge, Peng Qin-Mu, Yuan Yuan, Cheung Yiu-Ming, Lei Jia-Jia. Segmentation of Retinal Blood Vessels Using the Radial Projection and Semi-supervised Approach. Pattern Recognition, 2011, 44(10-11): 2314-2324 doi: 10.1016/j.patcog.2011.01.007 [33] He Kai-Ming, Zhang Xiang-Yu, Ren Shao-Qing, Sun Jian. Deep residual learning for image recognition. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, United States: IEEE, 2016. 770-778 [34] He Kai-Ming, Zhang Xiang-Yu, Ren Shao-Qing, Sun Jian. Identity mappings in deep residual networks. In: Proceedings of the 14th European Conference on Computer Vision. Amsterdam, Netherlands: Springer International Publishing, 2016. 630-645 [35] Christlein V, Bernecker D, Angelopoulou E. Writer identification using VLAD encoded contour-Zernike moments. In: Proceedings of the 13th International Conference on Document Analysis and Recognition. Tunis, Tunisia: IEEE, 2015. 906-910 [36] Spyromitros-Xioufis E, Papadopoulos S, Kompatsiaris I Y. A Comprehensive Study Over VLAD and Product Quantization in Large-Scale Image Retrieval. IEEE Transactions on Multimedia, 2014, 16(6): 1713-1728 doi: 10.1109/TMM.2014.2329648 [37] Fiel S, Sablatnig R. Writer Identification and Writer Retrieval Using the Fisher Vector on Visual Vocabularies. In: Proceedings of the 12th International Conference on Document Analysis and Recognition. Washington DC, USA: IEEE, 2013. 545-549 [38] Christlein V, Bernecker D, Maier A. Offline Writer Identification Using Convolutional Neural Network Activation Features. In: Proceedings of the 37th German Conference on Pattern Recognition. Aachen, Germany: Springer International Publishing, 2015. 540-552 -

下载:

下载: